Multi-Head Attention

Multi-Head Attention

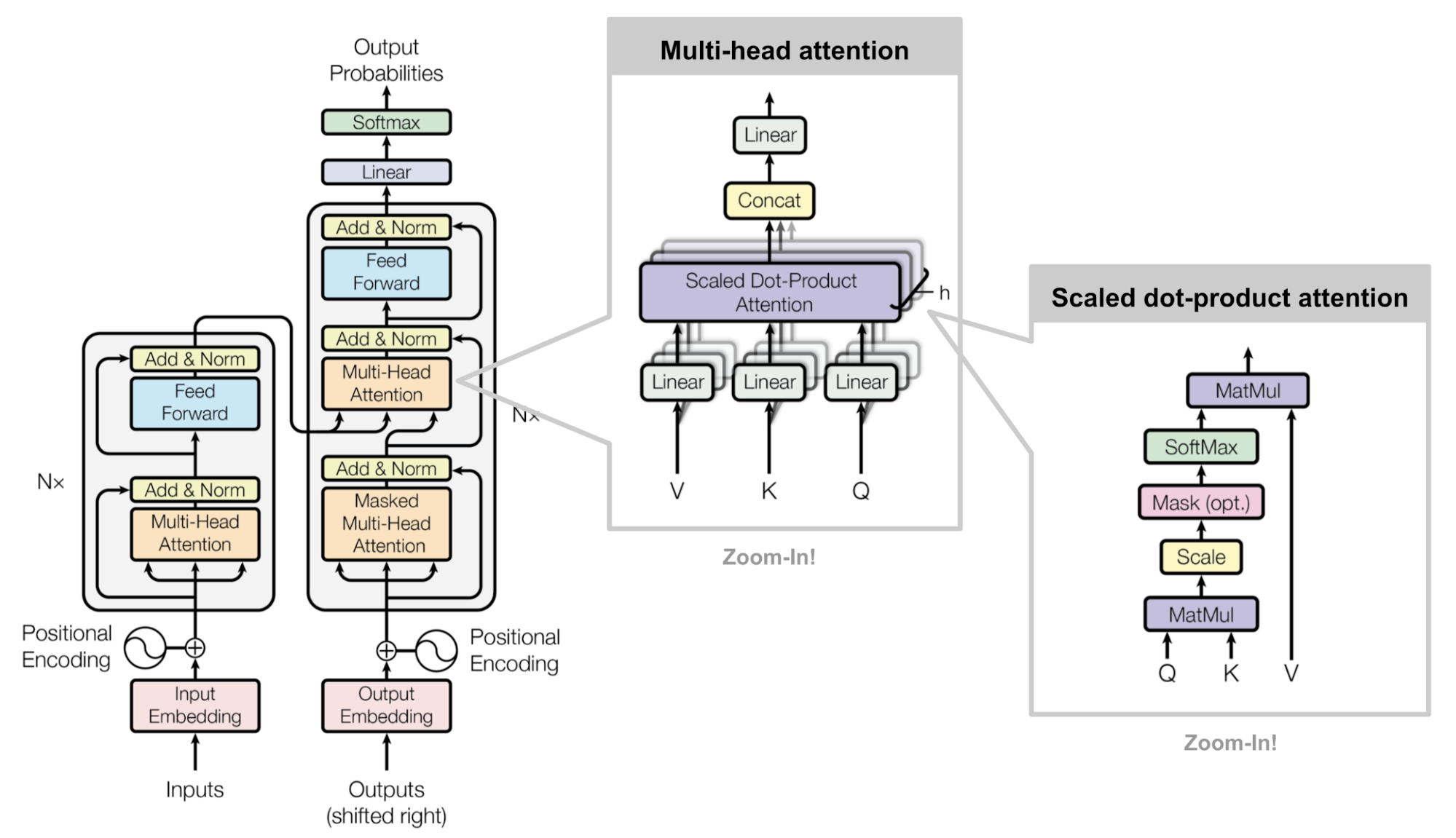

Self Attention 利用 Q、K、V均为同一个输入向量映射而来的Encoder-Decoder Attention,它可以无视词之间的距离直接计算依赖关系,能够学习一个句子的内部结构,实现也较为简单并且可以并行计算。

Multi-Head Attention同时计算多个Attention,并最终得到合并结果,通过计算多次来捕获不同子空间上的相关信息。

Reference Link:

- https://sungwookyoo.github.io/tips/study/Multihead_Attention/

- https://imzhanghao.com/2021/09/15/self-attention-multi-head-attention/